电脑变“卡”,很多时候并不是性能不够,而是散热与维护问题。本文记录了我对一台用了三年半的新机进行的排查:从软件优化、清灰、更换硅脂,到水冷报废、改用风冷,再到风扇调节与硬件升级。最后整理出一份维护计划和配置建议,供大家参考。

当电脑开始出现:开机变慢、应用响应迟缓、风扇噪音增大,甚至系统不稳定,原因通常有两个:

散热效率下降 → 硬件降频;

硬件性能不足 → 难以满足新应用需求。

我家里有两台台式机:

2014 年老机:Win10 系统,已用 11 年,依然运行流畅;

2022 年新机:i7-12700KF + RTX 3080Ti + 64GB,当时算高配。

没想到,用了三年半后,新机竟然开始“卡顿”。于是我开始了一次彻底的散热与维护排查,以下是全过程记录。

工具诊断:先确认方向

动手之前,先用工具排查:

👉 建议的排查顺序:

先看是否是软件进程异常;

若软件正常,再重点检查散热和温度。

例如,我曾因开启 ManicTime 的屏幕截图功能,导致切换应用时出现短暂卡顿,关闭后问题立刻消失。此外,另一个可能原因是电源。我也是在一次突然断电黑屏后才察觉到这一点,而这通常难以及时判断。

硬件维护:散热是关键

清灰:第一步必做

散热问题往往来自灰尘。它会堵塞进气口、覆盖鳍片,导致温度升高、风扇狂转、最终触发降频。

清洁前准备

彻底断电:关机,关闭电源供应器(PSU)背后的开关,并拔掉电源线。

选择通风环境:最好在室外或阳台,避免灰尘在室内弥漫。

防静电:在接触任何内部组件前,务必触摸机箱的金属部分以释放身体静电。

清洁步骤

拆卸侧板:打开机箱,暴露内部组件。

清洁防尘网:找到并取下机箱的防尘网(通常位于前面板、顶部和PSU下方),用水或刷子彻底清洁。

吹灰:推荐使用压缩空气罐,短促、有力地喷射,并始终保持罐体直立,以防液态推进剂喷出。(我这次用了530精密电器清洁剂,后发现有些人说可能有硅油残留。为安全起见,建议用压缩空气。)

清洁风扇:在对CPU、显卡、机箱和PSU风扇进行吹灰时,必须用手指或棉签轻轻固定住扇叶,防止其因气流过快旋转而损坏轴承。对于附着牢固的灰尘,可以用棉签蘸取少量高纯度(>90%)异丙醇进行擦拭。

清洁散热鳍片:将气流对准CPU和显卡散热器的金属鳍片,吹走积聚在内部的灰尘。

SSD 散热:小投入,立竿见影

我的 SSD 待机温度常年 60℃+。加装被动散热片后,降至 40–50℃,卡顿现象有所缓解。安装时注意:SSD 上的原厂贴纸可能是保修凭证,可自行选择是否移除。

👉 建议:SSD 长期高温会影响寿命,几十元的散热片立竿见影。

CPU 导热硅脂:3–5 年就要换

导热硅脂填充在 CPU 顶盖与散热器底座之间,保证热量高效传导。几年后会逐渐干涸、硬化,导致 CPU 温度升高。

更换步骤:

拆卸CPU散热器:首先断开CPU风扇的电源线,然后根据散热器的固定方式(卡扣或螺丝)将其从主板上取下。由于旧硅脂可能有粘性,轻轻旋转一下散热器有助于分离。

清理旧硅脂:使用无绒布(如咖啡滤纸)或超细纤维布,蘸取适量异丙醇,彻底擦拭CPU顶盖和散热器底座上的所有旧硅脂。

涂抹新硅脂:将一粒米或豌豆大小的新硅脂挤在CPU中央即可。无需手动涂抹,散热器的压力会自动将其均匀压开,形成一个薄而均匀的导热层。

重新安装散热器:将散热器垂直、平稳地放回CPU上,避免滑动。然后以对角线顺序分次拧紧螺丝,以确保压力均匀分布。

⚠️ 不要用消毒湿巾或低浓度酒精,避免水分残留损伤硬件。

我更换硅脂后,开机温度直飙到 100℃。排查发现,并不是涂抹问题,而是水冷散热器老化。

一体水冷报废 → 换风冷更安心

一体式水冷散热器寿命通常只有 3–5 年。随着时间推移,可能会出现以下问题:

冷却液损耗:虽然是密封系统,但仍有极少量冷却液会随时间蒸发,可能影响散热性能。

水泵故障:这是最常见的故障点。如果系统过热且您在iCUE等监控软件中看到水泵转速(RPM)为0,或听到水泵发出异常噪音,则可能意味着水泵已经损坏。

气泡问题:如果您听到水冷头或管道内有明显的“咕噜”或冒泡声,说明冷却循环内混入了空气。您可以尝试轻轻前后倾斜机箱,或将水泵转速设为最高运行一小时,以帮助将气泡排出水泵,聚集到冷排顶部。

我这套水冷用了三年半,性能已明显衰退,更换硅脂时甚至彻底坏掉。于是换上 200 元的双塔风冷,CPU 温度降至 30–50℃,比之前低了 20℃。

对比来看:

老机的风冷 → 11 年依然坚挺;

新机的水冷 → 3 年半报废。

👉 建议:能用风冷就别折腾水冷。

风道检查

更换风冷后,我在机箱顶部加装了两个 140mm 风扇。用 AIDA64 监控后发现:新风道是“负压”(出风大于进风)。虽然排热效率可能稍高,但容易从各处缝隙吸入灰尘。理想状态是略微正压,以兼顾散热与防尘。如果你搞不清风道怎么算,可以把传感数据都丢给AI分析。

于是我在 BIOS/UEFI 中调整了前置进风风扇的转速。操作流程是:开机时按特定键(通常是Del)进入BIOS设置,可以找到如“QFan Control”(华硕)、“Hardware Monitor”(微星)或“Smart Fan”(技嘉)等选项。在这里,您可以为CPU和机箱风扇选择预设模式(如静音、标准、性能),或根据温度手动设定风扇转速曲线。

调节时,注意记录主板接口与风扇的对应关系,便于后期调整。比如我的风扇布局如下:

进气:前 2(#3、#4) CPU 风冷:双塔,从前吹后 (#2) 排气:上 2(#1)、后 1(#5) GPU:自带 3 风扇 显卡风扇控制

与机箱风扇不同,显卡风扇需要专门的软件来进行控制。

通用第三方工具:MSI Afterburner 是广受欢迎的显卡超频和监控工具,它兼容NVIDIA和AMD的绝大多数显卡。用户可以通过其“风扇”设置选项,启用自定义的自动风扇控制,并拖动节点来设定一条与GPU温度相对应的风扇转速曲线。

品牌专用软件:

华硕(ASUS):提供GPU Tweak III软件,用于调整显卡参数,包括风扇控制、超频和电压调整。

AMD:Adrenalin Edition 驱动套件中内建了“性能调优”工具,允许用户直接控制显存频率、核心频率以及风扇速度。

NVIDIA:也提供官方工具,允许用户动态调整风扇速度,并可设置基于温度的自动控制。

原本还计划顺便给显卡更换硅脂,但考虑到(手残)风险太大就放弃了。好在显卡平时温度维持在 60℃ 左右,属于正常范围。

电源:最容易被忽视的隐患

电源问题对电脑的影响远比想象中严重,但又很难直接诊断。当电源老化或供电不稳时,可能出现以下症状:

电压波动 :导致 CPU/GPU 降频保护,表现为不规则的卡顿或掉帧;突然断电/黑屏 :高负载时电源供电不足,系统直接关机;啸叫/异响 :电源内部元器件老化,发出高频噪音。

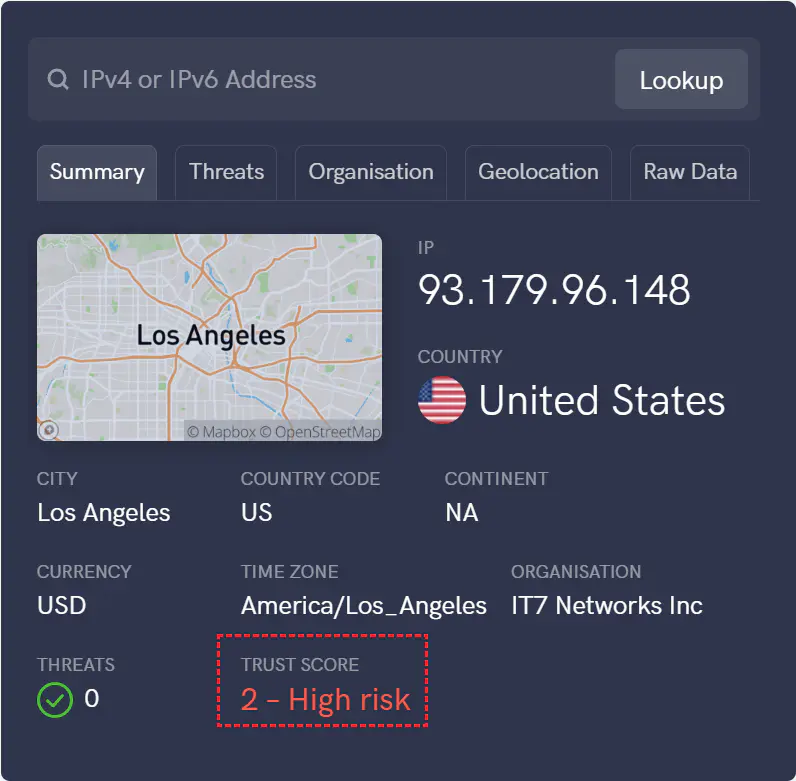

排查与处理建议:

直接接墙插 :电源线应插入墙壁插座,而非排插,以减少电压损耗和静电干扰。善用保修 :台式机电源通常有 5–10 年的质保。我这台电源在使用三年半后,进入冬天经常需要彻底断电放静电才能开机。联系店家后成功更换了新的电源。第一台换来的存在啸叫问题,再次申请更换后,第二台才恢复正常。更换全套模组线 :如果更换电源,建议一并换掉所有模组线(显卡供电线、主板 24pin、CPU 8pin、SATA 线等),避免老化线材带来的接触不良。

我这次卡顿的根本原因很可能就是电源。换新后,系统稳定性明显改善,再也没有出现过无故黑屏或随机卡顿。

⚠️ 电源故障不像温度问题那样有明确数据可看,排查时容易被忽略。如果前面的散热、软件都没问题,电源值得重点怀疑。

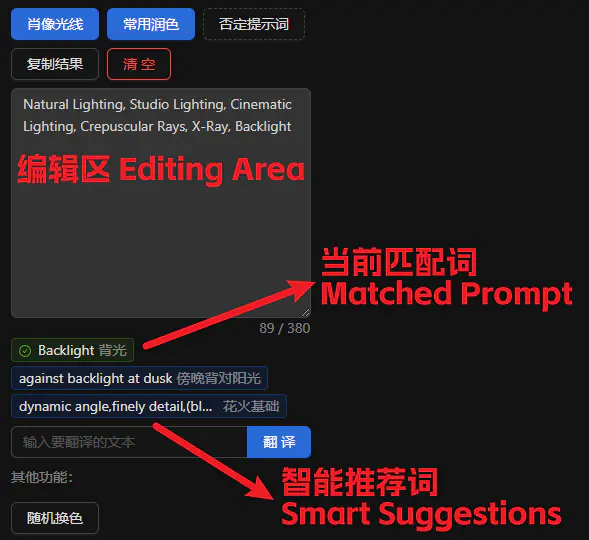

软件优化:MSI Utility V3

MSI Utility V3 是一款第三方开发的小工具,通过启用 Message Signal Interrupt (MSI) 模式,优化 Windows 的中断处理,避免传统线基中断容易因共享 IRQ 产生冲突而出现的高延迟(DPC/ISR 延迟)、随机卡顿。

十年内的电脑基本都支持 MSI Utility V3,我个人体验效果明显。AMD 显卡默认开启 MSI,NVIDIA 需手动切换。

使用方法:

下载 Msi-Utility-v3

以管理员身份运行 MSI_util_v3.exe

找到显卡(如 "NVIDIA GeForce RTX xxxx") → 勾选 “MSI” → 优先级设为 High

点击右上角 "Apply",重启电脑生效

推荐设置:显卡/声卡/网卡设为 High,NVMe 控制器设为 Normal。

硬件升级:低成本提升

SSD 升级

把系统盘从机械硬盘迁移到固态硬盘(SSD),提升最明显:开机时间大幅缩短、系统响应变快。

实现迁移主要有两种途径:

克隆:使用专用软件将旧硬盘的内容完整复制到新SSD上。这种方法保留了所有数据和设置,非常便捷,但有时也会将旧系统中的潜在问题一并带过来。

全新安装:在新SSD上全新安装Windows,然后重新安装应用程序并迁移个人数据。虽然步骤较多,但能保证最佳的性能和稳定性。

内存升级

内存不足时,系统会频繁调用虚拟内存(硬盘空间),造成明显卡顿。但在如今的大多数场景下,这个瓶颈已经不常见。对 Win11 用户来说,32GB 已经足够覆盖日常使用。我自己的 64GB 内存,常年占用不到 40%。

如果你要升级内存,要注意以下几点:

检查兼容性:确定主板支持的 DDR 类型、最大容量与频率。

双通道更优:例如 2×8GB 比单条 16GB 性能好。安装时需将内存条插入主板上指定的配对插槽中。

频率设置:部分内存需在 BIOS 启用扩展内存预设(XMP)才能跑满标称频率。例如,DDR5-6000 内存条一般默认仅以4800MHz的频率运行。

总结与维护计划

调整后,整机表现明显改善:

CPU 温度 ↓ 20℃

SSD 温度 ↓ 15℃

LatencyMon 测试一整天无异常

长期维护表

| 频率 | 任务 |

| :

5月底的赛里木湖,稍微下了点雨,上山后什么都看不见

5月底的赛里木湖,稍微下了点雨,上山后什么都看不见 拍摄于11月的绍兴东湖。说是湖,但面积其实很小,1个小时就逛完了

拍摄于11月的绍兴东湖。说是湖,但面积其实很小,1个小时就逛完了

封面图片拍摄于今年六月的新疆禾木。到了那,我才发现天能有多蓝,中午可以清晰的看见月亮。

封面图片拍摄于今年六月的新疆禾木。到了那,我才发现天能有多蓝,中午可以清晰的看见月亮。